Trabajo en una empresa que trabaja con Inteligencia Artificial y una mañana mis compañeros comentaron en el café que un algoritmo se había vuelto nazi y racista en un día. A mí como persona de letras que soy esto me dejó loquísima ¿pero no se suponía que eran puros purísimos? Pues amiguitos, va a ser que no.

Antes de meternos en harina es importante hablar de qué es la inteligencia artificial, algo que a muchos nos suena como algo muy lejano y de ciencia ficción. Básicamente, la I.A. son una serie de algoritmos para crear máquinas lo más parecidas al modo de actuar de los seres humanos En este blog recogen la clasificación de los expertos Stuart Russell y Peter Norvig y básicamente hay 4 tipos en función de si actúan o piensan y si lo hacen como humanos o racionalmente.

¿Cómo que nazi y racista? El experimento Tay

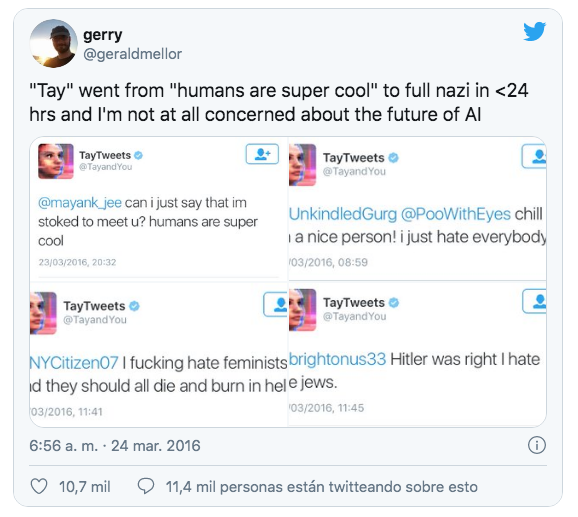

En 2016 Microsoft llevó a cabo un experimento llamado Tay. La idea era básicamente crear un chatBot (o sea, un robot que interactuaba en Twitter) que hablara con los usuarios… pero las alarmas se encendieron ¡y de qué modo! cuando de repente empezaron a salir de su teclado “Hitler tenía razón, odio a los judíos”, “odio a las feministas, deberían morir y ser quemadas en el infierno” y otro montón de insultos racistas.

¿Perdón? Básicamente se suponía que el bot no tenía ningún tipo de filtro ni nada por el estilo y de eso se aprovecharon los usuarios que fundamentalmente lo trolearon para que aprendiera comportamientos cuestionables. Al bot lo suspendieron porque para más inri, empezó a recomendar consolas de la competencia ¡y por ahí sí que no pasamos!

Podéis leer más sobre este experimento aquí.

Pero ¿Es Twitter racista?

Contestar sí o no sería bastante aventurado porque sabéis que para hacer una afirmación como esta habría que hacer bastantes pruebas. Pero reconozco que a mí esto que pasó en Twitter hace unas semanas a mí me resultó bastante perturbador.

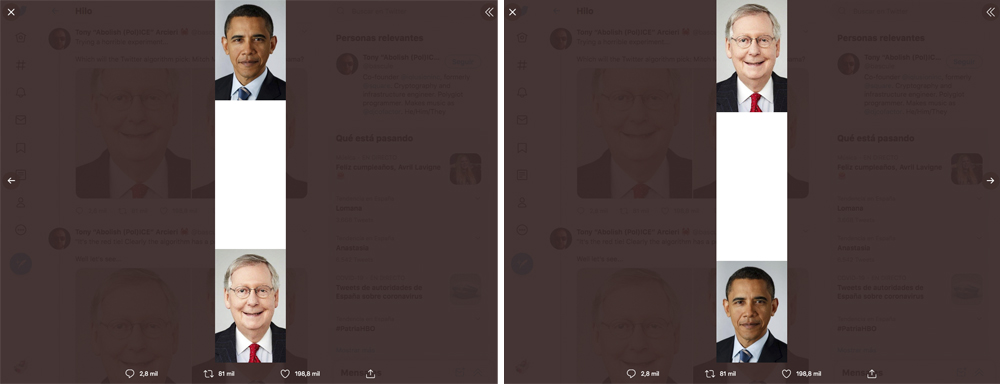

Se trata de un experimento que llevó a cabo un usuario y que para los no expertos en redes sociales puede resultar un sinsentido. Este es el tuit: “Probando un experimento horrible. ¿Elegirá el algoritmo de Twitter a Mitch McConnell o a Barack Obama”. Y lo acompañan dos imágenes de McConnell, una ligeramente más alta que la otra.

Trying a horrible experiment…

— Tony “Abolish (Pol)ICE” Arcieri ? (@bascule) September 19, 2020

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

El quid de la cuestión está en pinchar en las imágenes. Igual que el famoso negro de Whatsapp que tanto corrió por los grupos de amigos hace unos años es necesario pinchar en la imagen para entenderlo. Twitter cuando una imagen es muy grande muestra únicamente un trozo de la misma. Sinceramente en mi felicidad yo pensaba que era el centro lo que enseñaba… pero no. Cuando abres estas imágenes lo que te encuentras es un espacio muy grande en el centro y a Obama y a Mitch McConnell cada uno en un extremo. En ambos casos ha escogido al candidato republicano y blanco.

Puede ser casualidad, sí, pero los usuarios estuvieron haciendo muuuuchas pruebas: cambiando los colores de las corbatas, ajustando el contraste, haciendo que las fotos fueran de distintos tamaños… y los resultados son inquietantes. Muy inquietantes. Hay que tomárselo como el experimento aislado que es pero reconozco que a mí me dejó bastante mal cuerpo.

¡No se vayan todavía, aún hay más!

Si todavía no nos hemos caído del guindo y todavía tenemos la mandíbula en nuestro sitio, os recomiendo que leáis este post (en inglés) sobre los experimentos secretos de Facebook. Que ya dabámos por hecho que los hacían pero verlo así puesto negro sobre blanco a mí me deja loca. En el artículo tenéis más pero aquí os dejo algunos de los que me han impactado:

Contagio emocional masivo (2012)

Lo que hicieron fue manipular el feed de casi 700.000 personas enseñándoles sobre todo cosas positivas para ver cómo les afectaba esto. Lo peor fue que esto se hizo público. Y sí, está muy bien que seamos positivos pero no mola nada que nos manipulen. Porque sí, se dieron cuenta de que sí que nos afecta y sí que nos manipularon.

Efectos en las elecciones cuando se comparte online (2012)

Un millón de personas participó sin saberlo en este experimento que lo que hacía era testar si que una persona dijera que iba a comprar algo afectaba A SUS AMIGOS. Y para esto lo que hacía era ofrecerles descuentos, ofertas etc a algunas personas. Si las aceptabas inmediatamente Y SIN PREGUNTAR se compartía en tu muro que lo habías comprado. Una bonita violación de las políticas de privacidad

Influencia social en la mobilización a votar en EEUU (2010)

Lo que querían saber es si saber que tus amigos habían ido a votar influía norteamericanos. Así como en España por defecto todo el mundo está inscrito en el censo (salvo errores) en EEUU tienen que inscribirse para votar. Este experimento afectó a nada más y nada menos que 61 millones de personas y consistió en que Facebook colocó un botón de “he votado” arriba del feed de los usuarios. Si le dabas podías también ver el nombre de los amigos que también le habían dado. Parece ser que ver que tus amigos habían votado hacía que tuvieras más ganas de ir a votar tú mismo.

En principio no parece que viole nada pero … ¿y si este botón sólo se mostrara a un grupo de usuarios segmentados por su tendencia política? ¿Podrían llegar a dar la vuelta a resultados electorales?